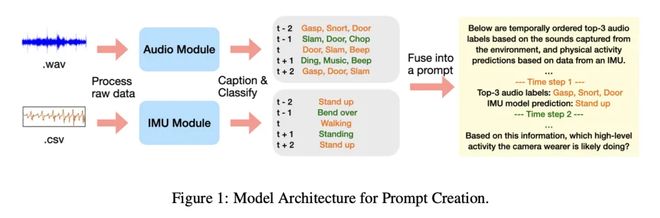

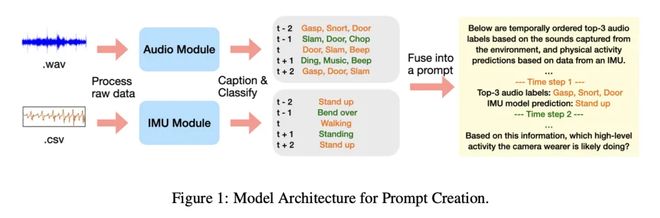

IT之家11 月 22 日消息,科技媒体 9to5Mac 昨日(11 月 21 日)发表博文,报道称,苹果在最新研究报告中表示,大型语言模型(LLM)可以通过分析音频和运动数据的文本描述来准确识别用户活动,未来可能会应用到 Apple Watch 上。这项技术被称为“Late Multimodal Sensor Fusion”,主要将LLM的识别能力与传统传感器数据相结合,即使传感器信息不足,也能准确识别用户执行的特定活动。主要研究方法颇具创新性。大型语言模型不直接处理用户录音或运动数据,而是分析专门微型模型 nab.uo 的文本描述。具体来说,音频模型生成描述声音环境的文本(例如“水声”),而基于惯性测量单元(IMU)的运动模型基因对动作类型的预测文本进行评分。这种方法不仅保护了用户的隐私,也证明了LLM在理解和整合大量文本信息进行复杂推理方面的强大能力。为了验证该方法,研究团队使用了 EGO4D 数据集,其中包含数千小时的第一人称视角视频。他们选择了12项日常活动,包括吸尘、做饭、洗碗、打篮球、举重等。每个样本时长为20秒。研究人员随后将小模型生成的文本描述输入到许多大型语言模型中,例如Google-Pro和阿里巴巴的gemini-13-pro,并在“零样本”(没有任何示例)和“单样本”(给出示例)两种情况下测试其识别效果。测试结果表明,即使没有任何特定的训练,大语言模型在活动识别任务中的表现也远远超出随机预测的水平,F1分数(精确度和重复性的衡量标准)调用)表现良好。当获得参考样本时,模型的准确性进一步提高。这项研究表明,利用 LLM 进行后期融合可以有效构建强大的多模态应用,而无需针对特定场景构建专门的模型,从而节省额外的内存和 com 资源。白苹果还发布了实验数据和代码,供其他研究人员重现和验证。

特别声明:以上内容(如有则包括照片或视频)由自媒体平台“网易号”用户上传发布。本平台仅提供信息存储服务。

注:以上内容(如有,包括图片、视频)仅提供信息存储服务。

IT之家11 月 22 日消息,科技媒体 9to5Mac 昨日(11 月 21 日)发表博文,报道称,苹果在最新研究报告中表示,大型语言模型(LLM)可以通过分析音频和运动数据的文本描述来准确识别用户活动,未来可能会应用到 Apple Watch 上。这项技术被称为“Late Multimodal Sensor Fusion”,主要将LLM的识别能力与传统传感器数据相结合,即使传感器信息不足,也能准确识别用户执行的特定活动。主要研究方法颇具创新性。大型语言模型不直接处理用户录音或运动数据,而是分析专门微型模型 nab.uo 的文本描述。具体来说,音频模型生成描述声音环境的文本(例如“水声”),而基于惯性测量单元(IMU)的运动模型基因对动作类型的预测文本进行评分。这种方法不仅保护了用户的隐私,也证明了LLM在理解和整合大量文本信息进行复杂推理方面的强大能力。为了验证该方法,研究团队使用了 EGO4D 数据集,其中包含数千小时的第一人称视角视频。他们选择了12项日常活动,包括吸尘、做饭、洗碗、打篮球、举重等。每个样本时长为20秒。研究人员随后将小模型生成的文本描述输入到许多大型语言模型中,例如Google-Pro和阿里巴巴的gemini-13-pro,并在“零样本”(没有任何示例)和“单样本”(给出示例)两种情况下测试其识别效果。测试结果表明,即使没有任何特定的训练,大语言模型在活动识别任务中的表现也远远超出随机预测的水平,F1分数(精确度和重复性的衡量标准)调用)表现良好。当获得参考样本时,模型的准确性进一步提高。这项研究表明,利用 LLM 进行后期融合可以有效构建强大的多模态应用,而无需针对特定场景构建专门的模型,从而节省额外的内存和 com 资源。白苹果还发布了实验数据和代码,供其他研究人员重现和验证。

特别声明:以上内容(如有则包括照片或视频)由自媒体平台“网易号”用户上传发布。本平台仅提供信息存储服务。

注:以上内容(如有,包括图片、视频)仅提供信息存储服务。

IT之家11 月 22 日消息,科技媒体 9to5Mac 昨日(11 月 21 日)发表博文,报道称,苹果在最新研究报告中表示,大型语言模型(LLM)可以通过分析音频和运动数据的文本描述来准确识别用户活动,未来可能会应用到 Apple Watch 上。这项技术被称为“Late Multimodal Sensor Fusion”,主要将LLM的识别能力与传统传感器数据相结合,即使传感器信息不足,也能准确识别用户执行的特定活动。主要研究方法颇具创新性。大型语言模型不直接处理用户录音或运动数据,而是分析专门微型模型 nab.uo 的文本描述。具体来说,音频模型生成描述声音环境的文本(例如“水声”),而基于惯性测量单元(IMU)的运动模型基因对动作类型的预测文本进行评分。这种方法不仅保护了用户的隐私,也证明了LLM在理解和整合大量文本信息进行复杂推理方面的强大能力。为了验证该方法,研究团队使用了 EGO4D 数据集,其中包含数千小时的第一人称视角视频。他们选择了12项日常活动,包括吸尘、做饭、洗碗、打篮球、举重等。每个样本时长为20秒。研究人员随后将小模型生成的文本描述输入到许多大型语言模型中,例如Google-Pro和阿里巴巴的gemini-13-pro,并在“零样本”(没有任何示例)和“单样本”(给出示例)两种情况下测试其识别效果。测试结果表明,即使没有任何特定的训练,大语言模型在活动识别任务中的表现也远远超出随机预测的水平,F1分数(精确度和重复性的衡量标准)调用)表现良好。当获得参考样本时,模型的准确性进一步提高。这项研究表明,利用 LLM 进行后期融合可以有效构建强大的多模态应用,而无需针对特定场景构建专门的模型,从而节省额外的内存和 com 资源。白苹果还发布了实验数据和代码,供其他研究人员重现和验证。

特别声明:以上内容(如有则包括照片或视频)由自媒体平台“网易号”用户上传发布。本平台仅提供信息存储服务。

注:以上内容(如有,包括图片、视频)仅提供信息存储服务。

推荐文章

推荐文章