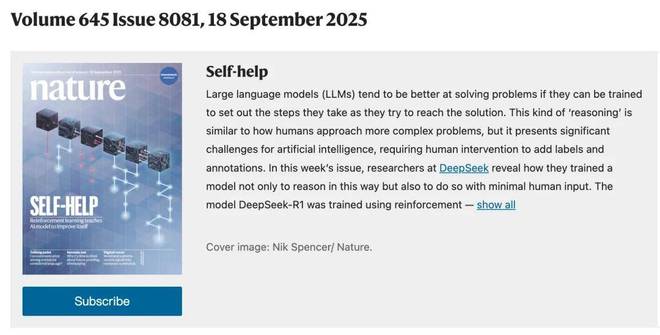

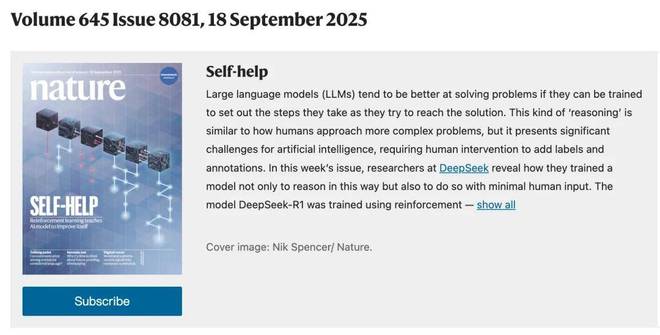

报告机器核心社论部门的机器的心脏令人惊讶!但是他值得!最新一期的《大自然封面》已成为对DeepSeek-R1的研究。也就是说,DeepSeek-R1:通过对LLMS推理的奖励的奖励,Deviceek于今年1月在Arxiv发表的一篇论文。与自然作用相对应的是Liang Wenfeng。纸张链接:https://www.nature.com/articles/s41586-025-09422- zin the LID推荐的简介,自然写:如果经过训练的大型模型可以计划解决问题所需的步骤,他们通常会更好地解决问题。这种“推理”类似于人们如何处理更复杂的问题,但是它给人工智能带来了巨大的挑战,并且需要添加标签和注释的手法媒介。在本周的日记中,Deviceek研究人员宣布如何与小型制造商一起培训模型并成为原因。 DeepSeek-R1模型是使用Reinfo训练的行动研究。在此类型的研究中,在正确回答数学问题时,模型将获得高奖励标记,如果错误的话,将受到惩罚。结果,它学会了推理 - 解决问题步骤并揭示这些步骤 - 更有可能提出正确的答案。它允许DeepSeek-R1在提供新问题的答案之前验证和反思,评估其绩效,从而提高其在编程和研究生级的科学问题中的表现。此外,在本周的杂志中,Kali称赞Skills是DeepSeek-R1的开放模型。值得注意的是,R1被认为是第一个通过《期刊》杂志当局同行评论的大型语言模型。 “这是一个受欢迎的之前。没有这个行业的标准,在大多数研发过程中公开共享,我们很难评估这些系统的潜在风险,”拥抱的机器研究工程师刘易斯·坦斯托尔(Lewis Tunstall)说。ND审稿人之一。为了响应审查,DeepSeek团队不仅避免了对纸质模型的拟人化描述,而且还添加了有关培训和安全数据类型类型的技术细节。 “通过严格的同行分析,毫无疑问,有效地验证了模型的可靠性和实践价值。其他公司必须遵循这种过渡。”显然,当前的Inai的企业在新闻发布会上充满了令人惊叹的示威游行和连续的令人耳目一新的排名。但是,如文章所述,可以“操纵”基准。模型的设计,方法和限制由独立的外部专家评估,这些专家可以有效地挤压其中的水分。对佩朗审计的审查是一个公平的“看门人”,要求AI公司从“王po出售瓜子”以稳定的证据来支持他们的陈述,并且可能会被重新注册。因此,Deptseek-R1论文本身就是科学的科学总而言之,但是作为第一个接受和通过对主要期刊的同行分析的LLM,其“程序价值”可能会更深。 LLM集成已经在独立的SystemPeer分析中找到,这是从“技术竞争”到“科学学科”的重要一步,对于防止工业障碍和发展公众信心至关重要。接下来,让我们回顾一下这项重要的研究。但是,还建议您查看自然界发表的论文,并提供更多细节。 Dept-R1多阶段管道基于大量管理数据,以提高模型性能。 DeepSeek的开发团队开辟了一个新的想法:尽管没有一个寒冷的开始,但没有细腻的(SFT),但巨大的加强研究可以显着提高该模型对模型理解的认识。如果您添加少量的冷启动数据,效果会更好。为此,他们开发了DeepSeek-R1-Zero。具体而言,deepseek-R1-Zero是三个独特的设计:首先,它采用了小组优化策略(GRPO)来降低培训成本。 GRPO不使用相同策略模型大小的审查模型,而是直接从组分数估算基线。第二个是奖励设计。如何设计确定RL优化方向的奖励。 DeepSeek提供的解决方案是使用两种辅助奖励机制:准确性和格式。第三点是训练模板。根据GRPO和奖励设计,开发团队设计了一个简单的模板,如表1所示,以指导基本模型。该模板需要首先给出识别过程,然后提供最终答案。该设计仅是受控的基本结构,并且不会对内容施加任何限制或偏见,例如反射性推理或特定问题解决方法的非强制性使用。最小的干预设计提供了清晰的观察RL模型开发的影响。在训练过程中,DeepSeek-R1-Zero表现出显着的自负能力。它学会了提出成千上万的推理令牌,并可以探索和完善更深入的思考过程。随着培训的加深,该模型还将发展一些先进的行为,例如反映和探索各种问题解决方法的能力。这些都不是预设,但是模型自然在增强环境中发展。尤其值得一提的是,开发团队naobsavoid是一个“ aha时刻”。在中期培训阶段,DeepSeek-R1-Zero学会通过重新评估初始程序来使精神时间更合理。这可能是一项增强研究的美:只要给出正确的奖励机制,您就可以独立开发先进的问题解决技术。但是,DeepSeek-R1-Zero仍然有一些局限性,例如不良阅读答案和MIXED语言。寒冷开始的采用研究与DeepSeek-R1-Zero不同。为了防止在RL培训的早期开始的不稳定冷阶段的出现,开发团队构建并收集了少量的R1数据,以将模型作为InitialRL Actor修复。为了收集此类数据,开发团队探讨了几种方法:获取几个样本的小屋样本,以直接激励模型通过反思和验证来提出详细的答案,以可读的格式收集DeepSeek-R1-Zero输出,并通过后处理人类隔离器来完善结果。 DeepSeek收集成千上万的冷数据开始适当地调整DeepSeek-V3基础作为RL的起点。与DeepSeek-R1-Zero相比,冷启动数据的优点包括:读取能力:主要的DeepSeek-R1-Zero限制是其内容通常不适合阅读。答案可以混合 - 可能是使用多种语言或缺乏降价格式来突出显示用户的答案。相反,在为R1创建冷启动数据时,开发团队设计了一个读取模式,其中包含每个响应和过滤器结束时的摘要是不友好的响应。潜力:通过仔细设计可以从以前的人类知识启动的数据模式,与DeepSeek-R1-Zero相比,开发团队的性能更好。开发团队认为,迭代培训是通过模型推理的更好方法。这项研究致力于在冷启动数据中进行DeepSeek-V3碱修复后进行加固的研究,开发团队采用了与DeepSeek-R1-Zero研究相同的大规模培训处理。此阶段着重于增强模型意识到的能力,尤其是在有理由的活动中,数学,科学和逻辑推理是合理的。为了减轻语言混合问题,开发团队INTROD练习了RL训练的语言的回报,该语言被计算为COT中语言目标单词的一部分。尽管消融实验表明这种对齐方式导致模型性能略有下降,但这种奖励与人类的偏好一致,更可读。最后,开发团队直接增加了推理和语言抵抗力的准确性的回报,以形成最终的奖励。然后,对微调模型进行了培训,以进行增强研究(RL),直到达到概念的任务为止。开发团队使用生成的检查站收集SFT(管理)数据以进行后续周期时,拒绝下沉和管理微调。此阶段结合了来自其他领域的数据,以增强写作,演奏和其他常见活动的模型能力。开发团队通过上述培训的检查站进行下降,以研究加固以调整识别和产生推理轨迹的提示。此阶段通过合并其他数据来扩展数据集,其中一些数据使用生成奖励模型来输入DeepSeek-V3中的基本事实和模型预测进行判断。此外,开发团队一直在拍摄混合语言,长段落和代码块的想法链接。对于每个提示,请绘制硅拉很多答案,然后保留正确的答案。最后,开发团队收集了近60万个相关培训样本。在这里研究了所有情况以进一步将模型与人类偏好相结合的采用,这里还实施了第二阶段的强化研究,旨在提高模型的利益和无害模型,同时提高推理能力。具体而言,研究人员使用了奖励信号和各种线索的组合来训练模型。对于构思数据,在DeepSeek-R1-Zero中构建的技术使用基于规则的奖励来指导学习过程在数学,代码和逻辑推理领域;对于一般数据,奖励模型用于在复杂和微妙的情况下捕获人类的偏好。最终,奖励信号和各种数据分布的集成使我们能够培训一个在推理方面表现良好的模型,同时欣赏有用性和无害。蒸馏:提供一小部分推理能力,以制作能够使用DeepSeek-R1等推理的更好的小型模型,开发团队直接使用800,000个样本与DeepSeek-R1结合使用了QWEN和LLAMA等开放资源模型。结果表明,这种简单的扭曲过程显着提高了理解小型模型的能力。多亏了许多技术中的上述创新,大量NG开发团队基准试验表明,DeepSeek-R1实现了与Sota行业SOTA SOTA INTA模型相当的困难能力。有关详细信息,请参阅以下结果S:有关更多技术细节,请参阅原始论文。

特别声明:上面的内容(包括照片或视频(如果有))已由“ NetEase”自助媒体平台的用户上传和发布。该平台仅提供信息存储服务。

注意:上面的内容(包括照片和视频(如果有))已由NetEase Hao用户上传和发布,该用户是社交媒体平台,仅提供信息存储服务。

报告机器核心社论部门的机器的心脏令人惊讶!但是他值得!最新一期的《大自然封面》已成为对DeepSeek-R1的研究。也就是说,DeepSeek-R1:通过对LLMS推理的奖励的奖励,Deviceek于今年1月在Arxiv发表的一篇论文。与自然作用相对应的是Liang Wenfeng。纸张链接:https://www.nature.com/articles/s41586-025-09422- zin the LID推荐的简介,自然写:如果经过训练的大型模型可以计划解决问题所需的步骤,他们通常会更好地解决问题。这种“推理”类似于人们如何处理更复杂的问题,但是它给人工智能带来了巨大的挑战,并且需要添加标签和注释的手法媒介。在本周的日记中,Deviceek研究人员宣布如何与小型制造商一起培训模型并成为原因。 DeepSeek-R1模型是使用Reinfo训练的行动研究。在此类型的研究中,在正确回答数学问题时,模型将获得高奖励标记,如果错误的话,将受到惩罚。结果,它学会了推理 - 解决问题步骤并揭示这些步骤 - 更有可能提出正确的答案。它允许DeepSeek-R1在提供新问题的答案之前验证和反思,评估其绩效,从而提高其在编程和研究生级的科学问题中的表现。此外,在本周的杂志中,Kali称赞Skills是DeepSeek-R1的开放模型。值得注意的是,R1被认为是第一个通过《期刊》杂志当局同行评论的大型语言模型。 “这是一个受欢迎的之前。没有这个行业的标准,在大多数研发过程中公开共享,我们很难评估这些系统的潜在风险,”拥抱的机器研究工程师刘易斯·坦斯托尔(Lewis Tunstall)说。ND审稿人之一。为了响应审查,DeepSeek团队不仅避免了对纸质模型的拟人化描述,而且还添加了有关培训和安全数据类型类型的技术细节。 “通过严格的同行分析,毫无疑问,有效地验证了模型的可靠性和实践价值。其他公司必须遵循这种过渡。”显然,当前的Inai的企业在新闻发布会上充满了令人惊叹的示威游行和连续的令人耳目一新的排名。但是,如文章所述,可以“操纵”基准。模型的设计,方法和限制由独立的外部专家评估,这些专家可以有效地挤压其中的水分。对佩朗审计的审查是一个公平的“看门人”,要求AI公司从“王po出售瓜子”以稳定的证据来支持他们的陈述,并且可能会被重新注册。因此,Deptseek-R1论文本身就是科学的科学总而言之,但是作为第一个接受和通过对主要期刊的同行分析的LLM,其“程序价值”可能会更深。 LLM集成已经在独立的SystemPeer分析中找到,这是从“技术竞争”到“科学学科”的重要一步,对于防止工业障碍和发展公众信心至关重要。接下来,让我们回顾一下这项重要的研究。但是,还建议您查看自然界发表的论文,并提供更多细节。 Dept-R1多阶段管道基于大量管理数据,以提高模型性能。 DeepSeek的开发团队开辟了一个新的想法:尽管没有一个寒冷的开始,但没有细腻的(SFT),但巨大的加强研究可以显着提高该模型对模型理解的认识。如果您添加少量的冷启动数据,效果会更好。为此,他们开发了DeepSeek-R1-Zero。具体而言,deepseek-R1-Zero是三个独特的设计:首先,它采用了小组优化策略(GRPO)来降低培训成本。 GRPO不使用相同策略模型大小的审查模型,而是直接从组分数估算基线。第二个是奖励设计。如何设计确定RL优化方向的奖励。 DeepSeek提供的解决方案是使用两种辅助奖励机制:准确性和格式。第三点是训练模板。根据GRPO和奖励设计,开发团队设计了一个简单的模板,如表1所示,以指导基本模型。该模板需要首先给出识别过程,然后提供最终答案。该设计仅是受控的基本结构,并且不会对内容施加任何限制或偏见,例如反射性推理或特定问题解决方法的非强制性使用。最小的干预设计提供了清晰的观察RL模型开发的影响。在训练过程中,DeepSeek-R1-Zero表现出显着的自负能力。它学会了提出成千上万的推理令牌,并可以探索和完善更深入的思考过程。随着培训的加深,该模型还将发展一些先进的行为,例如反映和探索各种问题解决方法的能力。这些都不是预设,但是模型自然在增强环境中发展。尤其值得一提的是,开发团队naobsavoid是一个“ aha时刻”。在中期培训阶段,DeepSeek-R1-Zero学会通过重新评估初始程序来使精神时间更合理。这可能是一项增强研究的美:只要给出正确的奖励机制,您就可以独立开发先进的问题解决技术。但是,DeepSeek-R1-Zero仍然有一些局限性,例如不良阅读答案和MIXED语言。寒冷开始的采用研究与DeepSeek-R1-Zero不同。为了防止在RL培训的早期开始的不稳定冷阶段的出现,开发团队构建并收集了少量的R1数据,以将模型作为InitialRL Actor修复。为了收集此类数据,开发团队探讨了几种方法:获取几个样本的小屋样本,以直接激励模型通过反思和验证来提出详细的答案,以可读的格式收集DeepSeek-R1-Zero输出,并通过后处理人类隔离器来完善结果。 DeepSeek收集成千上万的冷数据开始适当地调整DeepSeek-V3基础作为RL的起点。与DeepSeek-R1-Zero相比,冷启动数据的优点包括:读取能力:主要的DeepSeek-R1-Zero限制是其内容通常不适合阅读。答案可以混合 - 可能是使用多种语言或缺乏降价格式来突出显示用户的答案。相反,在为R1创建冷启动数据时,开发团队设计了一个读取模式,其中包含每个响应和过滤器结束时的摘要是不友好的响应。潜力:通过仔细设计可以从以前的人类知识启动的数据模式,与DeepSeek-R1-Zero相比,开发团队的性能更好。开发团队认为,迭代培训是通过模型推理的更好方法。这项研究致力于在冷启动数据中进行DeepSeek-V3碱修复后进行加固的研究,开发团队采用了与DeepSeek-R1-Zero研究相同的大规模培训处理。此阶段着重于增强模型意识到的能力,尤其是在有理由的活动中,数学,科学和逻辑推理是合理的。为了减轻语言混合问题,开发团队INTROD练习了RL训练的语言的回报,该语言被计算为COT中语言目标单词的一部分。尽管消融实验表明这种对齐方式导致模型性能略有下降,但这种奖励与人类的偏好一致,更可读。最后,开发团队直接增加了推理和语言抵抗力的准确性的回报,以形成最终的奖励。然后,对微调模型进行了培训,以进行增强研究(RL),直到达到概念的任务为止。开发团队使用生成的检查站收集SFT(管理)数据以进行后续周期时,拒绝下沉和管理微调。此阶段结合了来自其他领域的数据,以增强写作,演奏和其他常见活动的模型能力。开发团队通过上述培训的检查站进行下降,以研究加固以调整识别和产生推理轨迹的提示。此阶段通过合并其他数据来扩展数据集,其中一些数据使用生成奖励模型来输入DeepSeek-V3中的基本事实和模型预测进行判断。此外,开发团队一直在拍摄混合语言,长段落和代码块的想法链接。对于每个提示,请绘制硅拉很多答案,然后保留正确的答案。最后,开发团队收集了近60万个相关培训样本。在这里研究了所有情况以进一步将模型与人类偏好相结合的采用,这里还实施了第二阶段的强化研究,旨在提高模型的利益和无害模型,同时提高推理能力。具体而言,研究人员使用了奖励信号和各种线索的组合来训练模型。对于构思数据,在DeepSeek-R1-Zero中构建的技术使用基于规则的奖励来指导学习过程在数学,代码和逻辑推理领域;对于一般数据,奖励模型用于在复杂和微妙的情况下捕获人类的偏好。最终,奖励信号和各种数据分布的集成使我们能够培训一个在推理方面表现良好的模型,同时欣赏有用性和无害。蒸馏:提供一小部分推理能力,以制作能够使用DeepSeek-R1等推理的更好的小型模型,开发团队直接使用800,000个样本与DeepSeek-R1结合使用了QWEN和LLAMA等开放资源模型。结果表明,这种简单的扭曲过程显着提高了理解小型模型的能力。多亏了许多技术中的上述创新,大量NG开发团队基准试验表明,DeepSeek-R1实现了与Sota行业SOTA SOTA INTA模型相当的困难能力。有关详细信息,请参阅以下结果S:有关更多技术细节,请参阅原始论文。

特别声明:上面的内容(包括照片或视频(如果有))已由“ NetEase”自助媒体平台的用户上传和发布。该平台仅提供信息存储服务。

注意:上面的内容(包括照片和视频(如果有))已由NetEase Hao用户上传和发布,该用户是社交媒体平台,仅提供信息存储服务。

报告机器核心社论部门的机器的心脏令人惊讶!但是他值得!最新一期的《大自然封面》已成为对DeepSeek-R1的研究。也就是说,DeepSeek-R1:通过对LLMS推理的奖励的奖励,Deviceek于今年1月在Arxiv发表的一篇论文。与自然作用相对应的是Liang Wenfeng。纸张链接:https://www.nature.com/articles/s41586-025-09422- zin the LID推荐的简介,自然写:如果经过训练的大型模型可以计划解决问题所需的步骤,他们通常会更好地解决问题。这种“推理”类似于人们如何处理更复杂的问题,但是它给人工智能带来了巨大的挑战,并且需要添加标签和注释的手法媒介。在本周的日记中,Deviceek研究人员宣布如何与小型制造商一起培训模型并成为原因。 DeepSeek-R1模型是使用Reinfo训练的行动研究。在此类型的研究中,在正确回答数学问题时,模型将获得高奖励标记,如果错误的话,将受到惩罚。结果,它学会了推理 - 解决问题步骤并揭示这些步骤 - 更有可能提出正确的答案。它允许DeepSeek-R1在提供新问题的答案之前验证和反思,评估其绩效,从而提高其在编程和研究生级的科学问题中的表现。此外,在本周的杂志中,Kali称赞Skills是DeepSeek-R1的开放模型。值得注意的是,R1被认为是第一个通过《期刊》杂志当局同行评论的大型语言模型。 “这是一个受欢迎的之前。没有这个行业的标准,在大多数研发过程中公开共享,我们很难评估这些系统的潜在风险,”拥抱的机器研究工程师刘易斯·坦斯托尔(Lewis Tunstall)说。ND审稿人之一。为了响应审查,DeepSeek团队不仅避免了对纸质模型的拟人化描述,而且还添加了有关培训和安全数据类型类型的技术细节。 “通过严格的同行分析,毫无疑问,有效地验证了模型的可靠性和实践价值。其他公司必须遵循这种过渡。”显然,当前的Inai的企业在新闻发布会上充满了令人惊叹的示威游行和连续的令人耳目一新的排名。但是,如文章所述,可以“操纵”基准。模型的设计,方法和限制由独立的外部专家评估,这些专家可以有效地挤压其中的水分。对佩朗审计的审查是一个公平的“看门人”,要求AI公司从“王po出售瓜子”以稳定的证据来支持他们的陈述,并且可能会被重新注册。因此,Deptseek-R1论文本身就是科学的科学总而言之,但是作为第一个接受和通过对主要期刊的同行分析的LLM,其“程序价值”可能会更深。 LLM集成已经在独立的SystemPeer分析中找到,这是从“技术竞争”到“科学学科”的重要一步,对于防止工业障碍和发展公众信心至关重要。接下来,让我们回顾一下这项重要的研究。但是,还建议您查看自然界发表的论文,并提供更多细节。 Dept-R1多阶段管道基于大量管理数据,以提高模型性能。 DeepSeek的开发团队开辟了一个新的想法:尽管没有一个寒冷的开始,但没有细腻的(SFT),但巨大的加强研究可以显着提高该模型对模型理解的认识。如果您添加少量的冷启动数据,效果会更好。为此,他们开发了DeepSeek-R1-Zero。具体而言,deepseek-R1-Zero是三个独特的设计:首先,它采用了小组优化策略(GRPO)来降低培训成本。 GRPO不使用相同策略模型大小的审查模型,而是直接从组分数估算基线。第二个是奖励设计。如何设计确定RL优化方向的奖励。 DeepSeek提供的解决方案是使用两种辅助奖励机制:准确性和格式。第三点是训练模板。根据GRPO和奖励设计,开发团队设计了一个简单的模板,如表1所示,以指导基本模型。该模板需要首先给出识别过程,然后提供最终答案。该设计仅是受控的基本结构,并且不会对内容施加任何限制或偏见,例如反射性推理或特定问题解决方法的非强制性使用。最小的干预设计提供了清晰的观察RL模型开发的影响。在训练过程中,DeepSeek-R1-Zero表现出显着的自负能力。它学会了提出成千上万的推理令牌,并可以探索和完善更深入的思考过程。随着培训的加深,该模型还将发展一些先进的行为,例如反映和探索各种问题解决方法的能力。这些都不是预设,但是模型自然在增强环境中发展。尤其值得一提的是,开发团队naobsavoid是一个“ aha时刻”。在中期培训阶段,DeepSeek-R1-Zero学会通过重新评估初始程序来使精神时间更合理。这可能是一项增强研究的美:只要给出正确的奖励机制,您就可以独立开发先进的问题解决技术。但是,DeepSeek-R1-Zero仍然有一些局限性,例如不良阅读答案和MIXED语言。寒冷开始的采用研究与DeepSeek-R1-Zero不同。为了防止在RL培训的早期开始的不稳定冷阶段的出现,开发团队构建并收集了少量的R1数据,以将模型作为InitialRL Actor修复。为了收集此类数据,开发团队探讨了几种方法:获取几个样本的小屋样本,以直接激励模型通过反思和验证来提出详细的答案,以可读的格式收集DeepSeek-R1-Zero输出,并通过后处理人类隔离器来完善结果。 DeepSeek收集成千上万的冷数据开始适当地调整DeepSeek-V3基础作为RL的起点。与DeepSeek-R1-Zero相比,冷启动数据的优点包括:读取能力:主要的DeepSeek-R1-Zero限制是其内容通常不适合阅读。答案可以混合 - 可能是使用多种语言或缺乏降价格式来突出显示用户的答案。相反,在为R1创建冷启动数据时,开发团队设计了一个读取模式,其中包含每个响应和过滤器结束时的摘要是不友好的响应。潜力:通过仔细设计可以从以前的人类知识启动的数据模式,与DeepSeek-R1-Zero相比,开发团队的性能更好。开发团队认为,迭代培训是通过模型推理的更好方法。这项研究致力于在冷启动数据中进行DeepSeek-V3碱修复后进行加固的研究,开发团队采用了与DeepSeek-R1-Zero研究相同的大规模培训处理。此阶段着重于增强模型意识到的能力,尤其是在有理由的活动中,数学,科学和逻辑推理是合理的。为了减轻语言混合问题,开发团队INTROD练习了RL训练的语言的回报,该语言被计算为COT中语言目标单词的一部分。尽管消融实验表明这种对齐方式导致模型性能略有下降,但这种奖励与人类的偏好一致,更可读。最后,开发团队直接增加了推理和语言抵抗力的准确性的回报,以形成最终的奖励。然后,对微调模型进行了培训,以进行增强研究(RL),直到达到概念的任务为止。开发团队使用生成的检查站收集SFT(管理)数据以进行后续周期时,拒绝下沉和管理微调。此阶段结合了来自其他领域的数据,以增强写作,演奏和其他常见活动的模型能力。开发团队通过上述培训的检查站进行下降,以研究加固以调整识别和产生推理轨迹的提示。此阶段通过合并其他数据来扩展数据集,其中一些数据使用生成奖励模型来输入DeepSeek-V3中的基本事实和模型预测进行判断。此外,开发团队一直在拍摄混合语言,长段落和代码块的想法链接。对于每个提示,请绘制硅拉很多答案,然后保留正确的答案。最后,开发团队收集了近60万个相关培训样本。在这里研究了所有情况以进一步将模型与人类偏好相结合的采用,这里还实施了第二阶段的强化研究,旨在提高模型的利益和无害模型,同时提高推理能力。具体而言,研究人员使用了奖励信号和各种线索的组合来训练模型。对于构思数据,在DeepSeek-R1-Zero中构建的技术使用基于规则的奖励来指导学习过程在数学,代码和逻辑推理领域;对于一般数据,奖励模型用于在复杂和微妙的情况下捕获人类的偏好。最终,奖励信号和各种数据分布的集成使我们能够培训一个在推理方面表现良好的模型,同时欣赏有用性和无害。蒸馏:提供一小部分推理能力,以制作能够使用DeepSeek-R1等推理的更好的小型模型,开发团队直接使用800,000个样本与DeepSeek-R1结合使用了QWEN和LLAMA等开放资源模型。结果表明,这种简单的扭曲过程显着提高了理解小型模型的能力。多亏了许多技术中的上述创新,大量NG开发团队基准试验表明,DeepSeek-R1实现了与Sota行业SOTA SOTA INTA模型相当的困难能力。有关详细信息,请参阅以下结果S:有关更多技术细节,请参阅原始论文。

特别声明:上面的内容(包括照片或视频(如果有))已由“ NetEase”自助媒体平台的用户上传和发布。该平台仅提供信息存储服务。

注意:上面的内容(包括照片和视频(如果有))已由NetEase Hao用户上传和发布,该用户是社交媒体平台,仅提供信息存储服务。

推荐文章

推荐文章